Large Language Model

Transformer Architecutre

Positional Encoding

RNN 中的循环本质上保留了词的位置信息,但是由于 Transformer 采用多头自注意力机制 multi-head self-attension mechanism,每个词会同时经过 Transformer 中的 encoder 和 decoder,模型并不知道每个词的具体位置,因此 Transformer 给每个词增加了其相应的位置信息,称为「位置编码 positional encoding」。

常见的位置编码

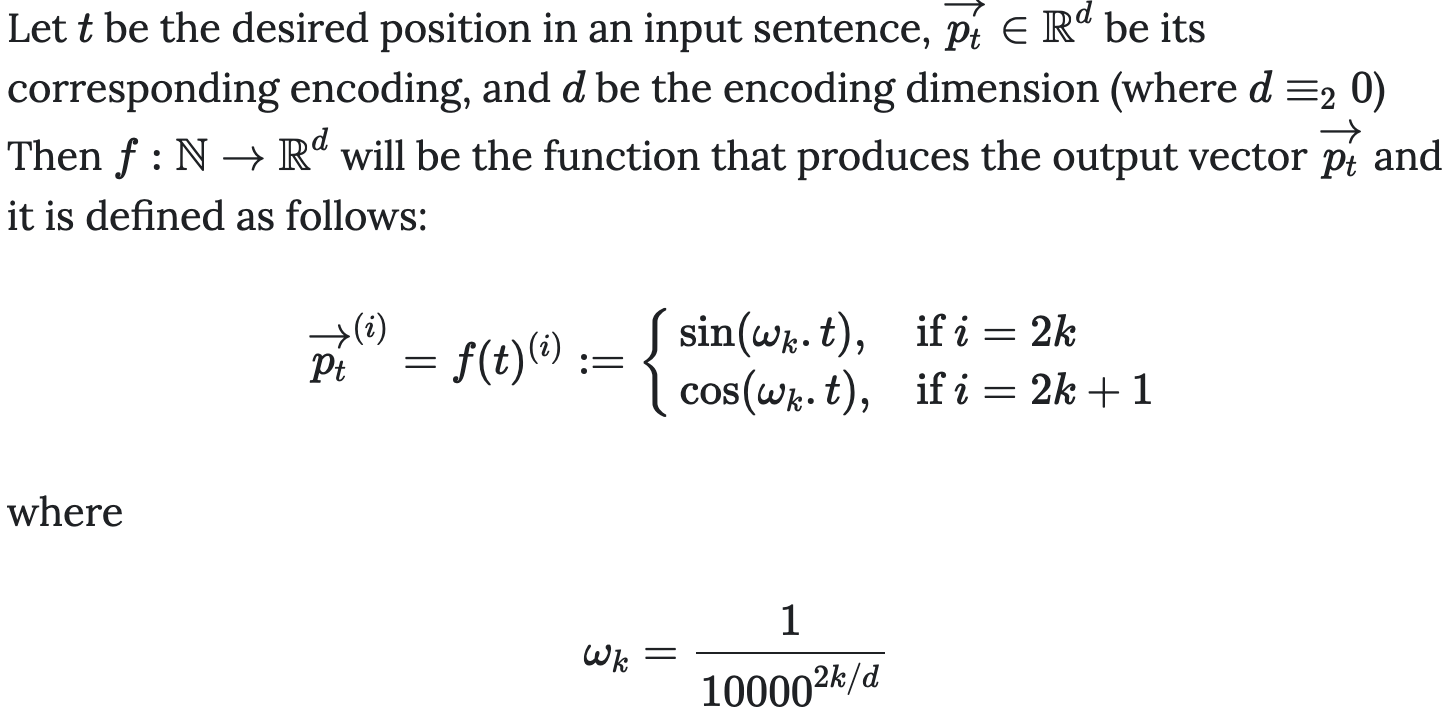

正弦余弦编码 Sinusoidal Positional Encoding

可学习位置编码 Learned Positional Encoding

将位置编码作为模型的可训练参数,在初始化之后与模型一起训练。缺点是位置编码长度固定,只能处理在训练时见过的最大序列长度,缺乏外推能力。

代表工作:BERT。

相对位置编码 Relative Positional Encoding

代表工作:Transformer-XL、XLNet、DeBERTa、T5。

旋转位置编码 Rotary Positional Encoding

当前主流的位置编码